はじめに

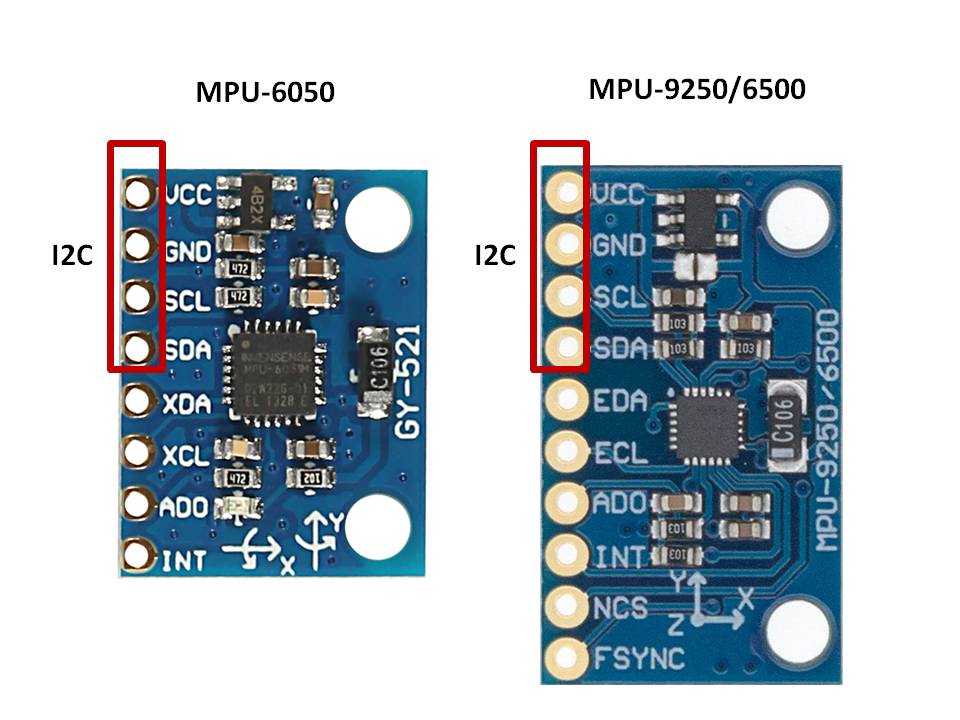

令和3年度発売の旧型機種のhayate_imu v2は多くの企業、学校法人のユーザー様にご利用いただいたことに、厚く御礼申し上げます。ありがとうございます。旧機種はv2.4までとリリースさせていただいておりますが、いまユーザー様のお手元にある旧バージョン製品のファームバージョンアップは、ユーザー様のもとで実施可能なので、詳細については、別途順次ご案内申し上げます。昨今の半導体ショックにより供給不足、価格高騰などの影響を受ける中、後継機種の開発を続けてきた結果、令和5年4月下旬より、9軸IMU/AHRS haya_imu v3.2の発売をお知らせさせていただきます。

製品紹介

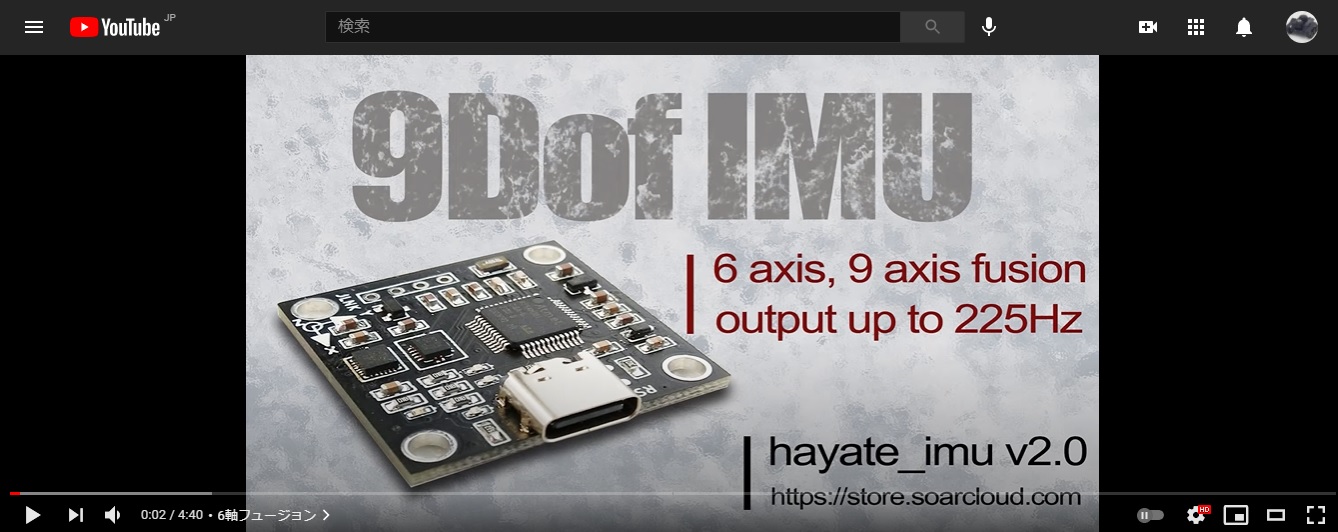

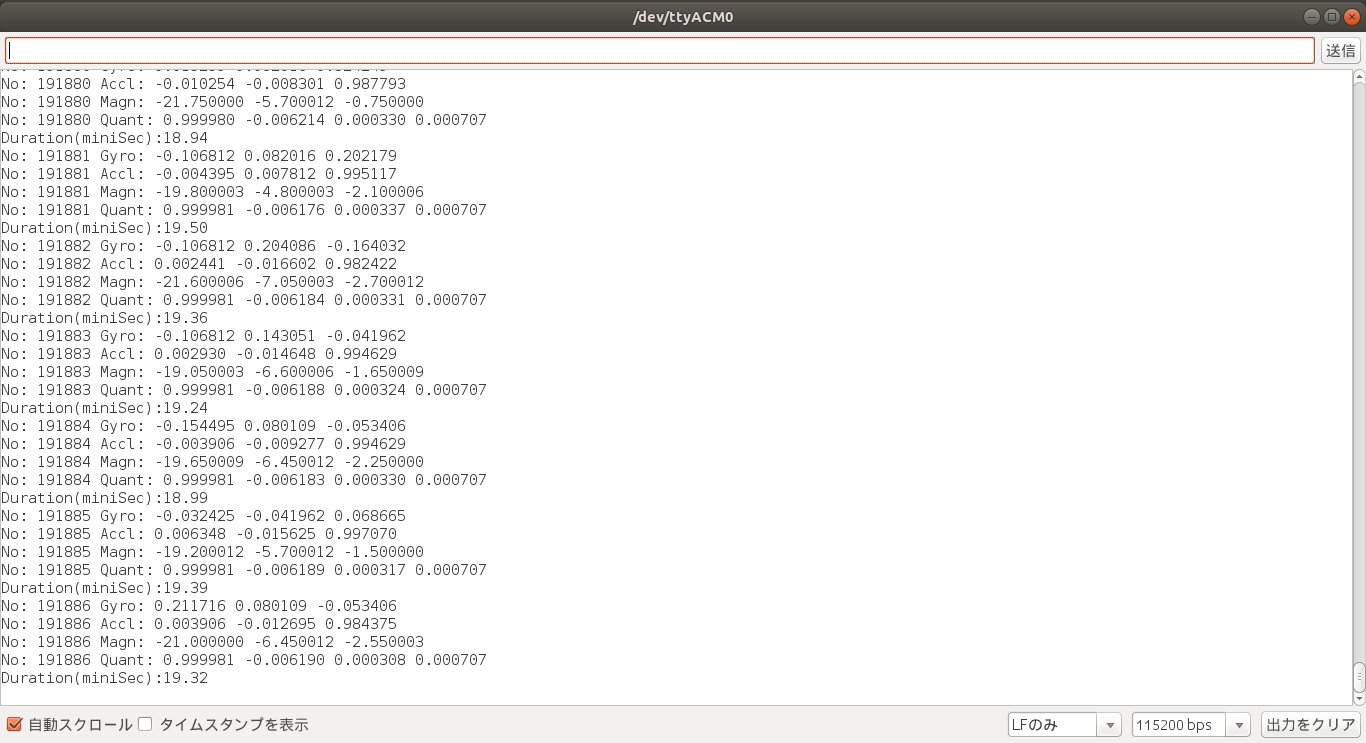

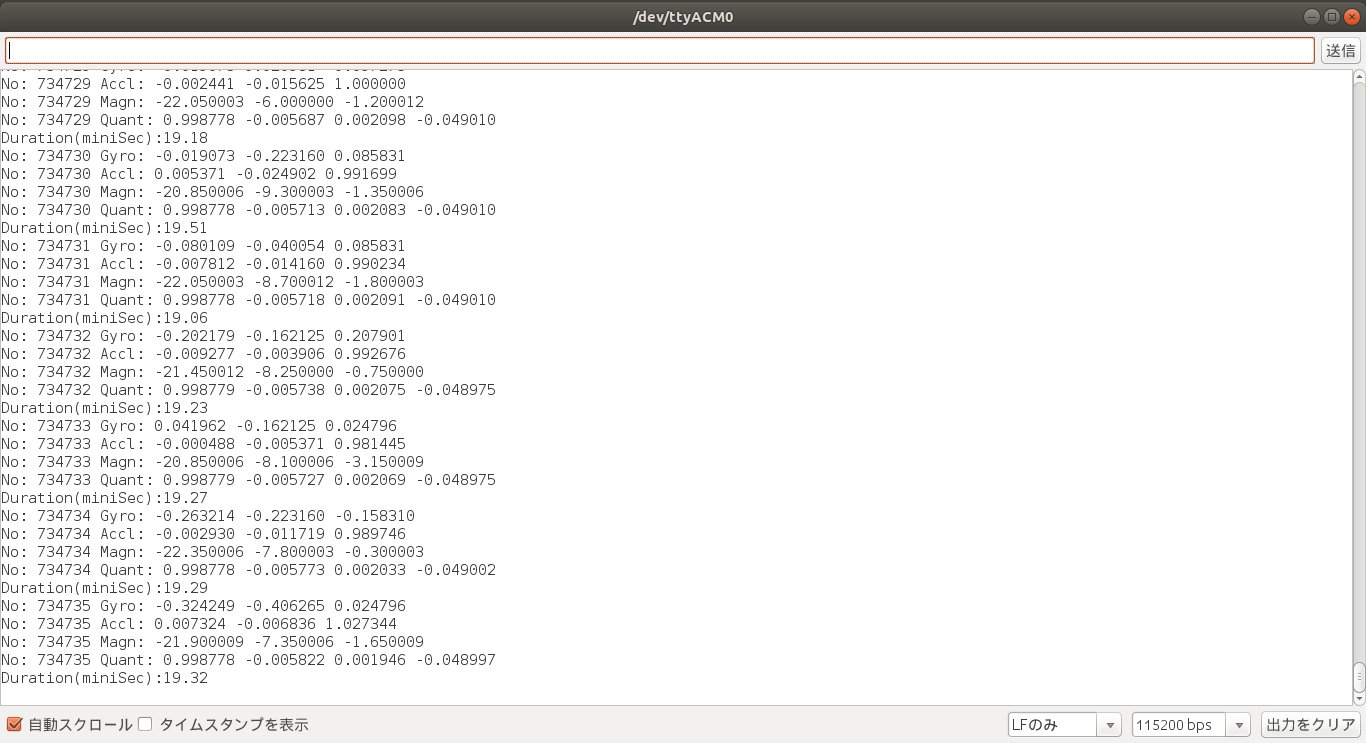

Cortex-M4 (クロック周波数120MHz)、新型6軸IMUのICM-42688、高精度3軸AMR方式地磁気センサMMC5983MAの実装により、通常出力モード、デモストレーションモード、キャリブレーションモード(初期バイアス測定)、6軸フュージョン回転ベクトルクォータニオン、9軸フュージョン回転ベクトルクォータニオン、3軸オイラー角の同時出力は最大1000Hzまで可能となります。ROS/ROS2とも対応しており、ドライバーはGithubよりダウンロードして製品とセットでご利用いただけます。

主な仕様

・型番 haya_imu v3.x

・内蔵チップ Microchip Cortex-M4(120MHz)、ICM-42688-VまたはICM-42688-P、MMC5983MA実装

・外部接続 USB2.0+ Type-C、USB+5V給電

・最大出力レート

- 6軸/9軸フュージョン回転ベクトル四元数 1000Hz

- 3軸オイラー角 1000Hz

- 3軸加速度(アクセル)データ 1000Hz

- 3軸角速度(ジャイロ)データ 1000Hz

- IMU内部温度データ 1000Hz

- 3軸地磁気(コンパス)データ 500Hz

・測定レンジ

- 加速度(アクセル)センサ ±8g

- 角速度(ジャイロ)センサ ±2000dps

- 地磁気(コンパス)センサ ±800µT

・バイアス測定補正 初期バイアス測定、動作時即時測定、内蔵補正機能あり

・消費電力 150mW以下(環境温度21℃ 実測値)

・寸法 38.0mm × 39.0mm × 4.8mm(突起物含む)

・取付穴 M3x4、隣り合う穴の中心間距離32.0mm

主な特長

・サービスモード 通常出力モード、デモンストレーションモード、キャリブレーションモード

・結果出力 6軸フュージョン回転クォータニオン、9軸フュージョン回転クォータニオン、3軸オイラー角1KHzまで同時出力、結果出力レートに関わらずIMU/地磁気センサのデータサンプリング周波数、フュージョン周波数は常に1000Hz/500Hzに設定済み

・初期バイアス測定 使用環境変化あった際に利用可能なキャリブレーションモードで最短数分程度で初期バイアス測定完了、MCUフラッシュに自動的に保存して、動作時に読み込んで即時バイアス測定&補正あり

・地磁気センサ温度補償 地磁気センサは、計測時間1msにわたるセットリセット計測(温度補償機能)使用済み

・磁気外乱による干渉 受けにくいことが当社実験(磁束密度約2G)にて確認済み

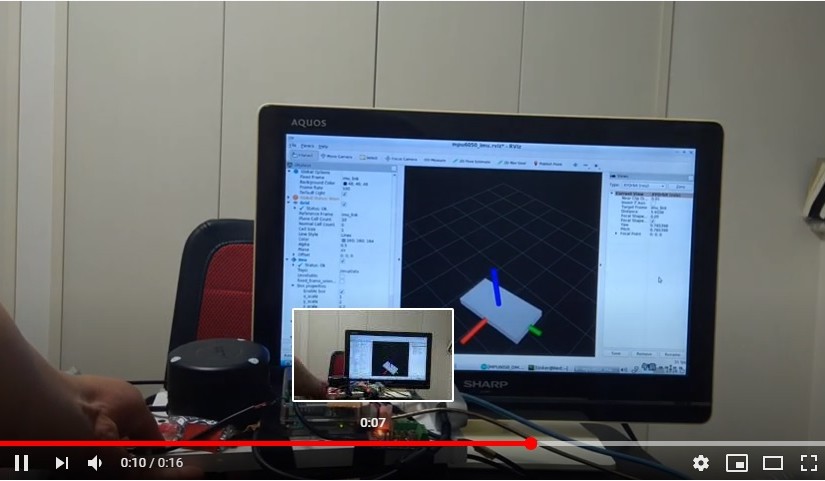

・ROS/ROS2対応 本体にはROS/ROS2ライブラリを実装せず、対向装置にドライバーインストールにより実現

詳細情報

【製品名称】haya_imu v3.x

【開発会社】ROBOT翔(株式会社翔雲)

【発売時期】令和5年4月下旬頃

【商品情報】9軸センサー6軸&9軸回転ベクトル 3軸オイラー角 MAX1000Hz同時出力 ROS/ROS2対応 USB接続 | ROBOT翔

参考情報

エンコーダ付きDCモータPID制御の実験-haya_imu応用例